在數據治理中臺的架構體系中,數據處理是一個承上啟下的關鍵環節。它不僅是數據從原始狀態轉化為可用資產的樞紐,更是確保數據質量、安全與價值釋放的核心引擎。本文將對數據治理中臺中的數據處理進行系統講解。

一、數據處理在數據治理中臺中的定位

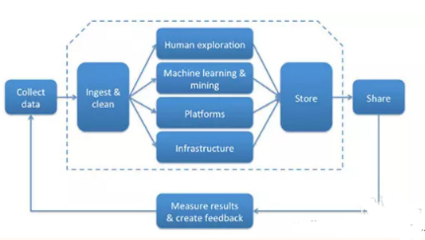

數據處理位于數據采集與數據服務之間,是數據治理中臺的“加工車間”。其主要職責是將來自不同源頭、格式各異的原始數據,通過一系列技術手段,轉化為標準化、高質量、可信任、易使用的數據資產,為上層的數據分析、智能應用與業務決策提供可靠“燃料”。

二、數據處理的核心任務與流程

一個完整的數據處理流程通常包含以下關鍵任務:

1. 數據接入與緩沖:

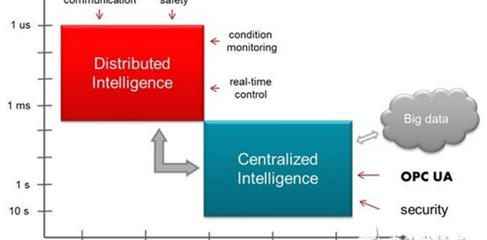

這是處理流程的起點。中臺需要能夠從各類數據源(如業務數據庫、日志文件、IoT設備、第三方API)穩定、實時或批量地接入數據,并利用消息隊列(如Kafka)或數據湖進行緩沖,以應對數據流量波動,實現解耦。

2. 數據清洗與標準化:

這是提升數據質量的關鍵步驟。主要工作包括:

- 去重:消除重復記錄。

- 補全:填充缺失值,可通過規則或算法進行智能補全。

- 糾錯:修正格式錯誤、邏輯矛盾的數據(如年齡為負數)。

- 標準化:統一日期、金額、單位等字段的格式,統一編碼和命名規范(如將“北京”、“北京市”統一為“北京市”)。

3. 數據轉換與集成:

將清洗后的數據按照目標模型進行轉換和整合。

- 格式轉換:如將JSON、XML轉換為結構化的表格式。

- 維度退化/降維:簡化數據結構。

- 數據關聯與融合:通過主鍵、外鍵等關聯不同來源的數據,形成完整的數據視圖,消除數據孤島。

4. 數據加工與建模:

基于業務需求,對數據進行深度加工,構建可復用的數據模型。

- 指標計算:生成業務關鍵指標(KPI),如銷售額、用戶留存率。

- 維度建模:構建事實表與維度表,形成星型或雪花型模型,便于分析。

- 標簽體系構建:為用戶、商品等實體打上豐富的標簽,支撐精準營銷與個性化服務。

5. 數據質量監控與稽核:

在整個處理流程中嵌入質量檢查點。通過定義質量規則(如完整性、唯一性、及時性、一致性規則),對數據處理各階段的結果進行自動化監控和報警,確保產出數據可信。

6. 數據存儲與分層:

將處理后的數據按照使用熱度和加工層次,存儲于不同的數據層中,典型的數據分層包括:

- ODS(操作數據層):存放近原樣的原始數據。

- DWD(數據明細層):存放經過清洗、標準化、維度關聯后的明細數據。

- DWS(數據匯總層):存放按主題域匯總的輕度聚合數據。

* ADS(應用數據層):存放為特定業務場景加工好的指標、寬表或報表數據。

這種分層結構便于數據管理、復用和高效計算。

三、數據處理的關鍵技術組件

數據治理中臺的數據處理能力通常由以下技術棧支撐:

- 計算引擎:

- 批量處理:Apache Spark, Hive, Flink(批模式),用于處理T+1的離線任務。

- 流式處理:Apache Flink, Apache Storm, Spark Streaming,用于處理實時數據流。

- 交互式查詢:Presto, Impala, ClickHouse,用于即席查詢與分析。

- 任務調度與編排:

- 工具:Apache Airflow, DolphinScheduler, Azkaban。負責管理和調度復雜的數據處理工作流,處理任務依賴、定時觸發和失敗重試。

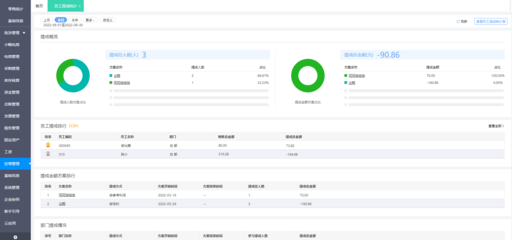

- 數據開發與運維平臺:

- 提供可視化的拖拽開發界面、SQL/腳本編輯環境、任務調試、版本管理和運維監控功能,降低數據處理任務的開發與管理門檻。

四、數據處理的核心價值

- 提升數據質量與可信度:通過系統化的清洗、監控流程,產出干凈、一致、可靠的數據。

- 打破數據孤島,形成統一視圖:整合多源數據,為業務提供“單一事實來源”。

- 提高數據開發效率與復用性:通過標準化、模型化和分層存儲,避免重復加工,實現“一次加工,多次復用”。

- 支撐數據價值快速釋放:高效、靈活的數據處理能力,能夠快速響應業務對數據指標、報表和分析的需求,賦能精細化運營與數據驅動決策。

- 保障數據安全與合規:在處理過程中,可集成脫敏、加密、權限控制等手段,確保數據安全合規使用。

###

數據處理是數據治理中臺將“數據資源”轉化為“數據資產”的核心生產鏈路。它不是一個孤立的工具,而是一套融合了流程、規范、技術和管理的綜合體系。建設強大的數據處理能力,是數據治理中臺成功落地、持續產生業務價值的關鍵所在。企業需要根據自身的數據規模、業務場景和技術棧,設計并迭代出最適合自己的數據處理架構與流程。